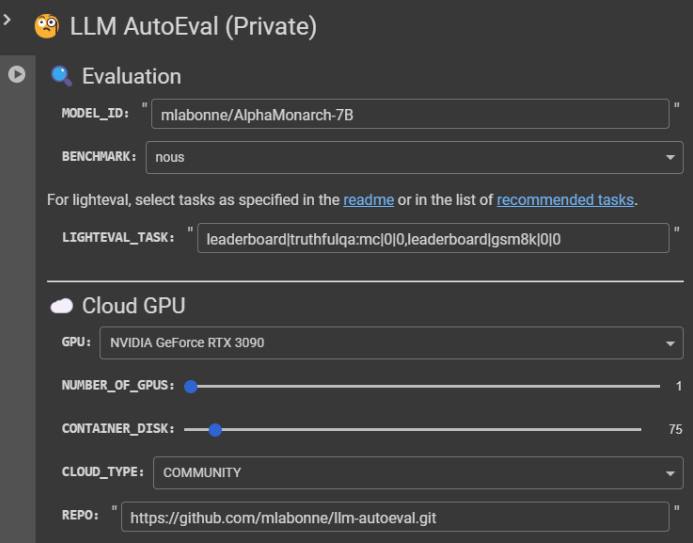

💫 LLM AutoEval — это проект, предлагающий простой способ бенчмаркинга LLM через Colab-блокнот, избавляя разработчиков от рутинной настройки тестовых сред. Достаточно указать название модели, выбрать benchmark и GPU — система сама развернёт инфраструктуру через RunPod и запустит оценку.

🌐 Система автоматически публикует результаты в формате GitHub Gist с возможностью сравнения с популярными моделями через интеграцию с YALL — альтернативным рейтингом языковых моделей. Для работы потребуются только API-токены RunPod и GitHub.

🔗 GitHub

@sqlhub

>>Click here to continue<<