Представь вечернюю лабораторию в MIT. Аспирант выключает монитор, уходит домой, а LLM остаётся. Ночью модель сама пишет себе новые задания, сочиняет пояснения, запускает тренировку, проверяет результат и выбирает, какой вариант тянет её дальше. К утру производительность на задачах растёт так, будто над ней трудились ещё десять инженеров.

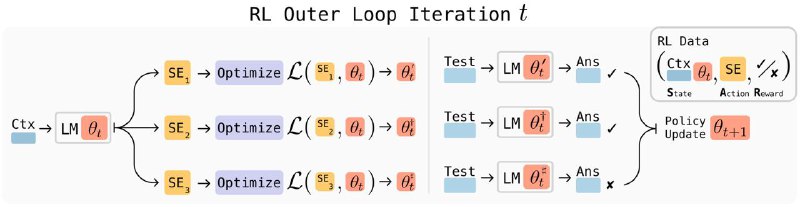

Так работает SEAL — схема «самообучения через само-редактирование». Модель формулирует запрос «чему мне не хватает», генерирует фейковый датасет, меняет веса и сразу тестирует результат. За полезную правку получает награду, за лишнюю — штраф. На энциклопедических вопросах собственные «конспекты» оказались полезнее материалов GPT-4.1. А в головоломках прирост драматический: от нуля до 72,5 % точности за несколько итераций блуждания.

И что?

Такая автодидактика сокращает путь от гипотезы до улучшенной модели до одной ночной сессии — без человека в цикле. Значит, в Production появятся ИИ, которые сами закрывают слабые места, генерируя новый опыт по требованию. Для рынка это вызов: нужны стандарты аудита «само-обучения», новые метрики доверия и стоп-краны на случай, если ночное творчество свернёт не туда. А для продуктов — возможность ускорять эволюцию функций темпом непрерывной сборки.

>>Click here to continue<<