Create: Update:

خلاصهتر فکر کن

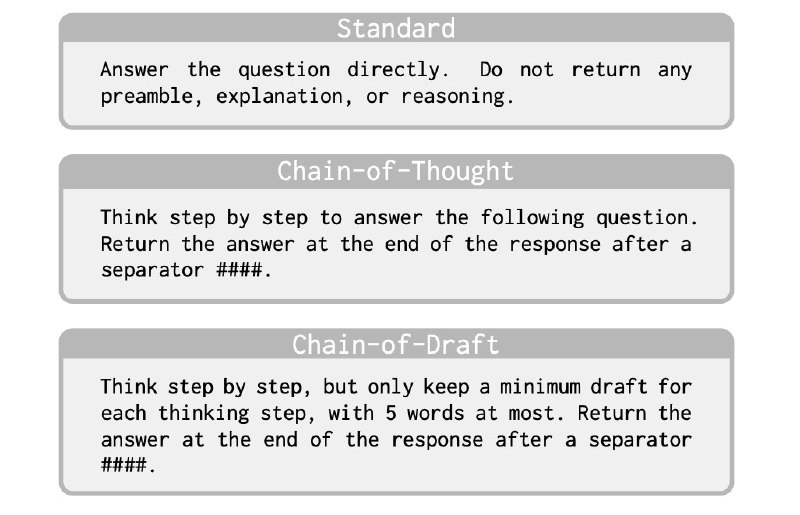

از اونجایی که در مسائل استدلالی (reasoning) ، مدل برای رسیدن به جواب نهایی، باید دنباله افکار میانی رو به شکل CoT تولید کنه، یکی از دردهای آزاردهنده اینه که باید گاهی توکنهای زیادی اون وسط تولید بشن و این امر هم هزینه پولی و هم هزینه زمانی زیادی داره. حالا با توجه به این نکته، این که چطور توکنهای کمتری تولید کنیم و در عین حال دقت مطلوبتری رو حفظ کنیم مسالهی پیشروی ماست.

به تازگی کار جالبی اومده با عنوان Chain of Draft یا CoD که همون CoT هست با این تفاوت که در پرامپت از مدل خواسته میشه که هر سگمنت استدلالی (reasoning) که میخواد خروجی بده حداکثر ۵ کلمه طول داشته باشه. نتایجش جالب شده و نشون داده که با میزان توکن و در نتیجه latency خیلی کمتر تونسته دقت قابل رقابت با CoT رو حفظ کنه و حتی بعضی جاها بهتر از اون نتیجه بده. خلاصه که یکی از جهتهای آینده احتمالا اینه که چطور مدلهایی داشته باشیم که کاراتر فکر کنند.

لینک پیپر:

https://arxiv.org/abs/2502.18600

#read

#paper

@nlp_stuff

از اونجایی که در مسائل استدلالی (reasoning) ، مدل برای رسیدن به جواب نهایی، باید دنباله افکار میانی رو به شکل CoT تولید کنه، یکی از دردهای آزاردهنده اینه که باید گاهی توکنهای زیادی اون وسط تولید بشن و این امر هم هزینه پولی و هم هزینه زمانی زیادی داره. حالا با توجه به این نکته، این که چطور توکنهای کمتری تولید کنیم و در عین حال دقت مطلوبتری رو حفظ کنیم مسالهی پیشروی ماست.

به تازگی کار جالبی اومده با عنوان Chain of Draft یا CoD که همون CoT هست با این تفاوت که در پرامپت از مدل خواسته میشه که هر سگمنت استدلالی (reasoning) که میخواد خروجی بده حداکثر ۵ کلمه طول داشته باشه. نتایجش جالب شده و نشون داده که با میزان توکن و در نتیجه latency خیلی کمتر تونسته دقت قابل رقابت با CoT رو حفظ کنه و حتی بعضی جاها بهتر از اون نتیجه بده. خلاصه که یکی از جهتهای آینده احتمالا اینه که چطور مدلهایی داشته باشیم که کاراتر فکر کنند.

لینک پیپر:

https://arxiv.org/abs/2502.18600

#read

#paper

@nlp_stuff

خلاصهتر فکر کن

از اونجایی که در مسائل استدلالی (reasoning) ، مدل برای رسیدن به جواب نهایی، باید دنباله افکار میانی رو به شکل CoT تولید کنه، یکی از دردهای آزاردهنده اینه که باید گاهی توکنهای زیادی اون وسط تولید بشن و این امر هم هزینه پولی و هم هزینه زمانی زیادی داره. حالا با توجه به این نکته، این که چطور توکنهای کمتری تولید کنیم و در عین حال دقت مطلوبتری رو حفظ کنیم مسالهی پیشروی ماست.

به تازگی کار جالبی اومده با عنوان Chain of Draft یا CoD که همون CoT هست با این تفاوت که در پرامپت از مدل خواسته میشه که هر سگمنت استدلالی (reasoning) که میخواد خروجی بده حداکثر ۵ کلمه طول داشته باشه. نتایجش جالب شده و نشون داده که با میزان توکن و در نتیجه latency خیلی کمتر تونسته دقت قابل رقابت با CoT رو حفظ کنه و حتی بعضی جاها بهتر از اون نتیجه بده. خلاصه که یکی از جهتهای آینده احتمالا اینه که چطور مدلهایی داشته باشیم که کاراتر فکر کنند.

لینک پیپر:

https://arxiv.org/abs/2502.18600

#read

#paper

@nlp_stuff

از اونجایی که در مسائل استدلالی (reasoning) ، مدل برای رسیدن به جواب نهایی، باید دنباله افکار میانی رو به شکل CoT تولید کنه، یکی از دردهای آزاردهنده اینه که باید گاهی توکنهای زیادی اون وسط تولید بشن و این امر هم هزینه پولی و هم هزینه زمانی زیادی داره. حالا با توجه به این نکته، این که چطور توکنهای کمتری تولید کنیم و در عین حال دقت مطلوبتری رو حفظ کنیم مسالهی پیشروی ماست.

به تازگی کار جالبی اومده با عنوان Chain of Draft یا CoD که همون CoT هست با این تفاوت که در پرامپت از مدل خواسته میشه که هر سگمنت استدلالی (reasoning) که میخواد خروجی بده حداکثر ۵ کلمه طول داشته باشه. نتایجش جالب شده و نشون داده که با میزان توکن و در نتیجه latency خیلی کمتر تونسته دقت قابل رقابت با CoT رو حفظ کنه و حتی بعضی جاها بهتر از اون نتیجه بده. خلاصه که یکی از جهتهای آینده احتمالا اینه که چطور مدلهایی داشته باشیم که کاراتر فکر کنند.

لینک پیپر:

https://arxiv.org/abs/2502.18600

#read

#paper

@nlp_stuff

>>Click here to continue<<

NLP stuff