Как правильно реализовать PPO? 37 деталей, которые почти никто не указывает

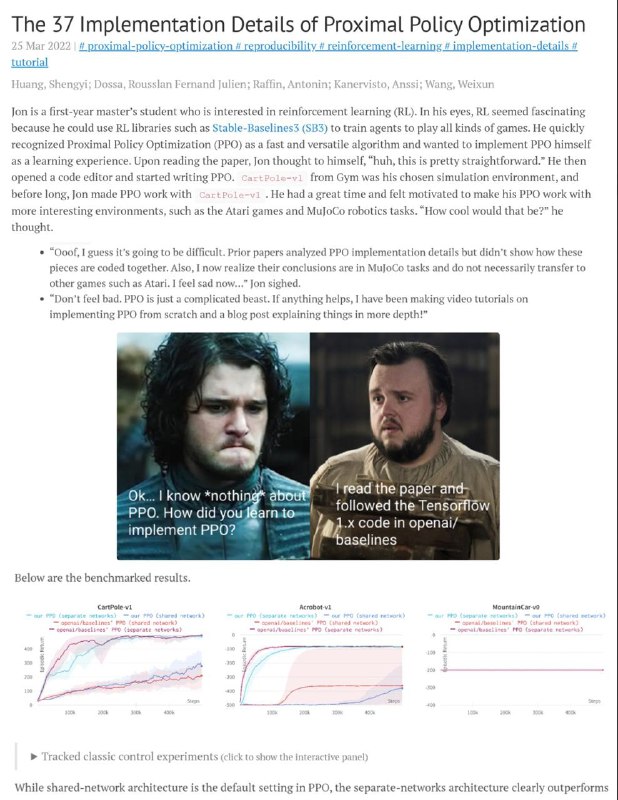

Полезное чтиво Исследователи из ICLR собрали 37 практических нюансов, без которых реализация Proximal Policy Optimization (PPO) часто оказывается нестабильной или неэффективной.

🔧 В статье разобраны:

• 13 базовых деталей — без них PPO просто не будет работать стабильно

• 9 дополнительных при работе с изображениями (например, Atari)

• 9 нюансов для задач с непрерывным действием (робототехника и физика)

• 6 универсальных оптимизаций, улучшающих сходимость и результат

💡 Примеры включают:

– обработку rewards перед обучением

– правильное использование GAE

– нормализацию входных данных

– трюки с масштабированием advantages

– обработку градиентов и dropout

📌 Почему это важно:

Эти детали влияют на производительность и стабильность PPO, но почти всегда остаются "между строк" в статьях и туториалах. Без них модель может "учиться", но не достигать ожидаемых результатов.

🔗 Оригинальный разбор + код: https://iclr-blog-track.github.io/2022/03/25/ppo-implementation-details/

#ReinforcementLearning #PPO #RL #DeepLearning #ICLR

>>Click here to continue<<