🧠 NVIDIA: будущее ИИ-агентов — не в LLM, а в SLM

Большие языковые модели (LLM) — мощные, но громоздкие.

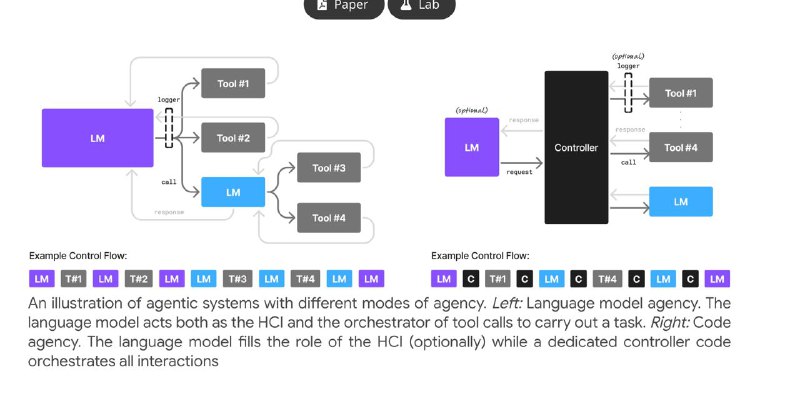

Для агентных систем, где ИИ выполняет простые задачи снова и снова, это — перебор.

🔍 В новом исследовании NVIDIA делает смелое заявление:

маленькие языковые модели (SLM) — это:

✅ Достаточно умно

✅ Намного дешевле

✅ Идеально подходит для агентных систем

Почему SLM — лучше для ИИ-агентов:

⚡ Меньше задержка, меньше ресурсов

📱 Работают на устройствах (в том числе offline)

🔁 Легко и быстро обучаются под конкретную задачу

🧩 Отлично сочетаются в модульных системах: каждый агент — своя модель

Что предлагает NVIDIA:

1. Ставить на SLM для снижения стоимости и ускорения работы

2. Комбинировать модели: использовать LLM только там, где без них не обойтись

3. Проектировать гибкие системы, где каждый агент делает одну задачу, но хорошо

4. Дообучать SLM под узкие роли — это быстро и эффективно

💡 SLM — это не упрощение, а оптимизация.

Умные, быстрые и дешёвые агенты — вот куда движется AI-индустрия.

📄 Читай полное исследование: research.nvidia.com/labs/lpr/slm-agents

>>Click here to continue<<