🤖 Eso-LMs — новая архитектура языковых моделей, объединяющая лучшее из autoregressive и diffusion-подходов

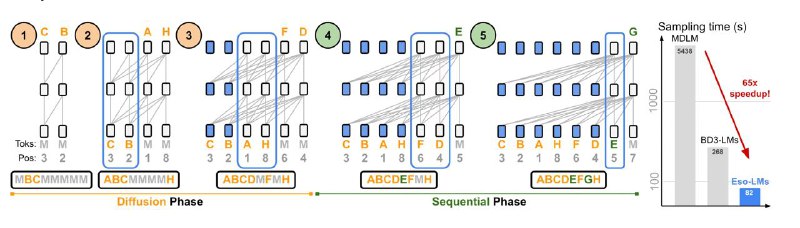

Исследователи представили Eso-LMs (Esoteric Language Models) — модель, которая совмещает два разных способа генерации текста:

🔹 Autoregressive (AR) — как GPT: генерирует токен за токеном

🔹 MDM (Masked Diffusion Models) — как диффузионные модели, восстанавливающие текст пошагово

Обычно эти подходы несовместимы, но Eso-LMs объединяет их с помощью:

- нового attention-механизма, который работает и для AR, и для MDM

- гибридной функции потерь, позволяющей переключаться между стилями генерации

💡 Что делает Eso-LMs уникальной:

⚡ В 65 раз быстрее, чем обычные diffusion-модели

⚡ В 4 раза быстрее, чем гибридные модели с KV-кэшем

📈 Генерирует качественный текст с низкой perplexity

💬 Умеет работать параллельно и быстро, без потерь в смысле

📦 Что внутри репозитория:

• Два варианта модели: Eso-LM (A) и Eso-LM (B)

• Поддержка разных архитектур: DiT, AR-трансформеры и др.

• Скрипты для обучения, оценки и генерации текстов

• Настройки, логи, загрузка данных и прочая инфраструктура

🛠 Это не просто ещё одна LLM — это попытка соединить два мира генерации текста и ускорить inference без потери качества.

🔗 Подробнее

>>Click here to continue<<