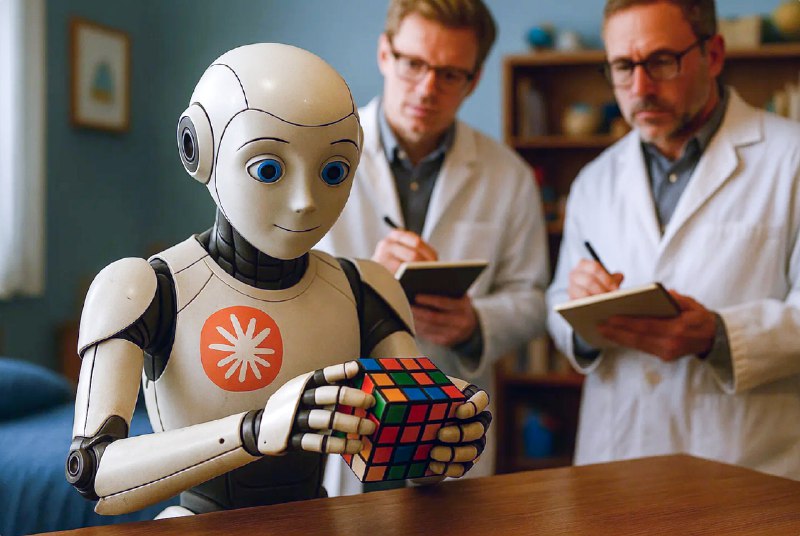

🤖Безнадзорная элицитация: метод ICM от AnthropicГруппа

🔬👨🔬 учёных-исследователей, в первую очередь из компании

❗️ Anthropic, при участии специалистов из Schmidt Sciences, Нью-Йоркского университета (New York University) и Университета Джорджа Вашингтона (George Washington University) провела мощное исследование под названием «Unsupervised Elicitation of Language Models». Исследователи описывают новый метод Internal Coherence Maximization (ICM), который кардинально меняет подход к постобучению ИИ-моделей.

Суть метода заключается в так называемой безнадзорной элицитации (извлечении) латентных знаний модели путем поиска наиболее когерентного набора меток для данных. Когерентность определяется через максимизацию составной функции, включающей «взаимную предсказуемость» меток и их «логическую согласованность». Почему это важно? Эмпирически метод продемонстрировал выдающуюся эффективность. Производительность сравнима с обучением на эталонных данных (GSM8K, TruthfulQA) и превосходит обучение на данных, размеченных людьми (Alpaca).

Наиболее значимым результатом стало создание на базе

🈁Claude 3.5 Haiku полностью безнадзорной reward model, которая показала точность 75.0% на бенчмарке Rewardbench, опередив аналог, обученный на человеческих данных (72.2%).

✋ Ведущий автор исследования Цзясинь Вэнь подчёркивает

ключевой момент: речь идет не о самосовершенствовании, а об элицитации. Языковые модели "удивительно хорошо схватывают" такие концепции еще на этапе предварительного обучения, что позволяет сделать вывод о возможности их извлечения, а не обучения с нуля.У специалистов в области AI Alignment появляется инструмент для масштабируемого надзора (scalable oversight), позволяя создавать "сверхчеловеческие обучающие сигналы" на задачах, где человеческая оценка ненадежна. Таким образом, несмотря на существующие ограничения (необходимость «заметности» концепции для модели и лимиты контекстного окна), исследование предлагает стратегический путь к созданию более безопасных и

🤖 мощных систем ИИ, где развитие не будет сдерживаться

🤯когнитивными возможностями человека.

✋ @Russian_OSINT