Как сообщает AP, проведённое журналистами издания расследование выявило ряд серьезных проблем в работе инструмента транскрибации Whisper, разработанного компанией OpenAI. Несмотря на громкие заявления OpenAI о высокой точности и надежности модели, специалисты и инженеры отмечают, что Whisper, предназначенная для преобразования/расшифровки речи в текст, склонна к сильным

Журналисты приводят один из примеров: на приёме во время диалога между врачом и пациентом прозвучала безобидная фраза, которая была переведена Whisper в текст с упоминанием 💊вымышленного лекарства, которого никогда не существовало.

🇺🇸Сейчас галлюцинирующая ИИ-модель активно внедряется в 🏥больницах США для автоматической расшифровки диалогов между

В ходе расследованиям выяснилось, что аудиозаписи диалогов между врачами и пациентами удаляются сразу после транскрибации «по соображениям безопасности», что делает невозможным проведение объективной проверки всех косяков Whisper cо стороны журналистов.

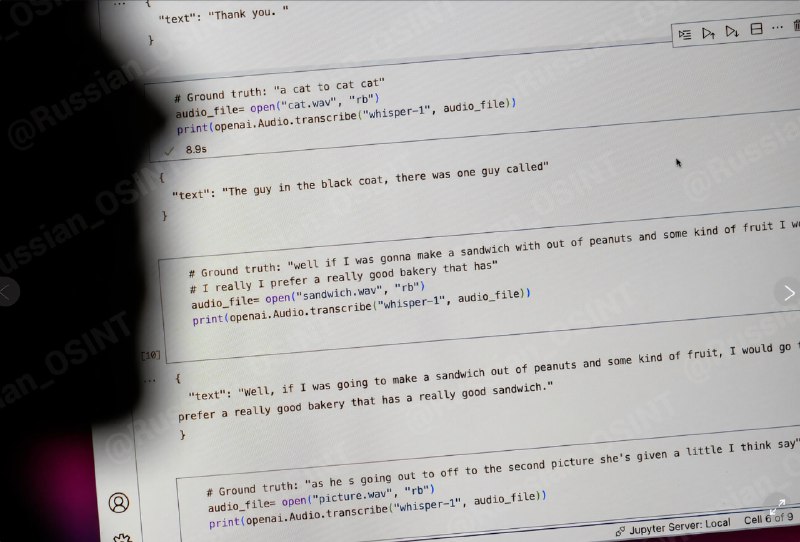

Тем не менее, журналисты попросили разных ученых-исследователей вместе с инженерами оценить в целом "косячность" модели и пришли к неутешительным результатам:

1️⃣ По данным одного из исследователей Университета Мичигана, 8 из 10 проверенных расшифровок Whisper содержали вымышленные элементы или факты.

2️⃣ Один из инженеров сообщил: 50% случаев "галлюцинаций" на выборке из 100 часов аудио.

3️⃣ Около 40% данных при расшифровке были потенциально опасны или вводили в заблуждение из-за "галлюцинаций".

4️⃣ Проблема распространена даже в качественных аудиофайлах, где присутствует отличное качество звука. Было обнаружено 187 галлюцинаций в более чем 13 000 чистых аудиофрагментах.

5️⃣ Whisper иногда используется для создания субтитров для слабослышащих, подвергая риску эту группу людей, если модель начинает выбрасывать "галлюцинации".

Законодатель штата Калифорния Ребекка Бауэр-Кахан рассказала, что в начале этого года она отвела одного из своих детей к врачу и отказалась подписывать форму, которая требовала от неё разрешения на передачу аудиозаписи

>>Click here to continue<<