📦 Fluent Bit теряет логи в Kubernetes? Вот как это пофиксили в ArteraAI

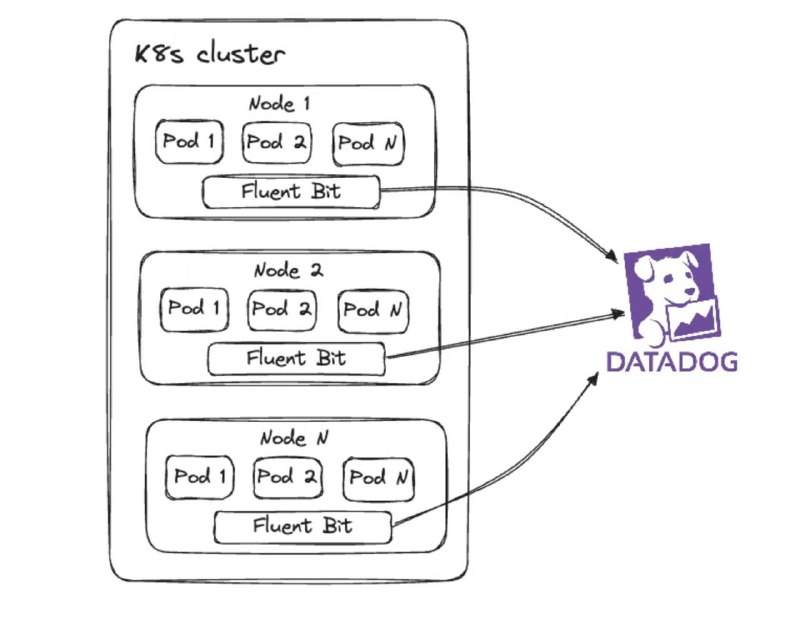

Команда ArteraAI столкнулась с загадочным исчезновением логов: job успешно выполнялся, Fluent Bit читал логи… но они не доходили до DataDog. Почему?

🔍 Оказалось, что Fluent Bit не справлялся с нагрузкой:

- логи буферизуются в памяти (по 2МБ чанки),

- при переполнении mem_buf_limit входные плагины ставятся на паузу,

- данные теряются, особенно при всплесках активности.

💡 Решение: включили файловую буферизацию.

Теперь логи сначала пишутся в память, потом на диск — никаких пауз и потерь.

‼️ Но даже после фикса… логи не находились в DataDog. Почему?

🔥 Проблема была в отсутствии Kubernetes-метаданных. Fluent Bit не всегда корректно добавлял поля pod, namespace, cluster, и логи оказывались в слепой зоне мониторинга.

📌 Вывод:

1. Следите за backpressure (`paused (mem buf overlimit)`).

2. Включайте файловую буферизацию при высоких нагрузках.

3. Проверяйте, что Kubernetes Filter добавляет все нужные метаданные.

Подробности: https://arteraai.medium.com/optimizing-kubernetes-log-aggregation-tackling-fluent-bit-buffering-and-backpressure-challenges-fb3129dc5031

@DevOPSitsec

>>Click here to continue<<